苹果iOS 26的AI功能比Siri强多少?

iOS 26的AI功能相比Siri有了显著的提升,以下是对两者功能的详细对比:

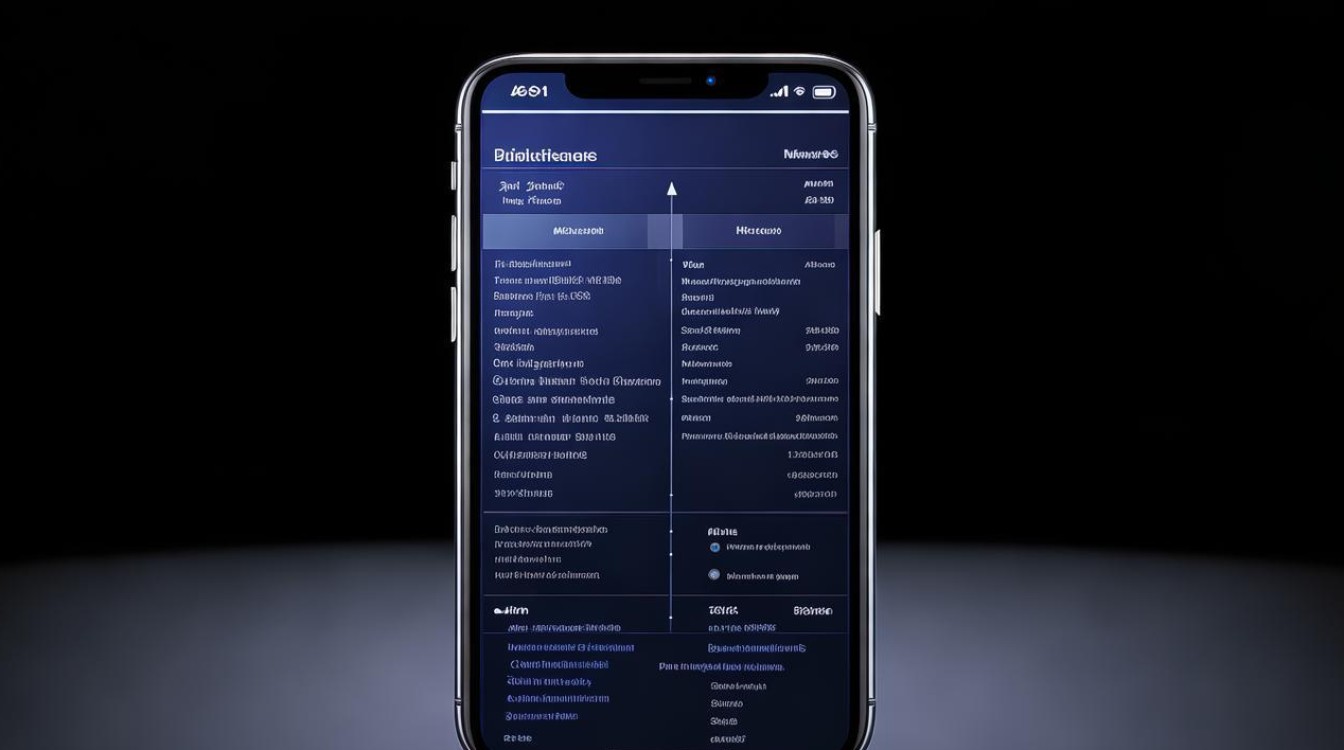

| 功能特性 | Siri(当前版本) | iOS 26 AI功能 |

|---|---|---|

| 交互方式 | 依赖唤醒词(如“Hey Siri”),需明确指令 | 支持自然对话,减少机械式唤醒,交互更流畅 |

| 场景感知 | 基础语音识别,需手动设置个人信息(如地址、生日) | 主动学习用户习惯,动态调节硬件功耗,实现“无感续航提升” |

| 多任务处理 | 单一任务响应(如播放音乐、发送信息) | 支持复杂任务处理(如自动接电话、筛选重要内容) |

| 第三方集成 | 仅限苹果生态内服务,封闭性强 | 首次支持第三方语音助手,打破生态壁垒 |

| 视觉交互 | 关联功能 | 新增“屏幕感知”功能,可识别屏幕内容并执行操作(如编辑图片) |

核心优势对比分析

-

自然语言处理能力

- Siri:仍需依赖固定语法和关键词,提醒我明天下午3点开会”,若用户表述模糊(如“明天几点开会?”),可能无法准确响应。

- iOS 26 AI:通过深度学习优化语义理解,支持上下文连贯对话,用户问“今天天气如何?”后,可继续追问“那明天呢?”,系统能自动关联上下文。

-

主动智能与自动化

- Siri:以被动响应为主,需用户明确触发(如“Hey Siri,关闭闹钟”)。

- iOS 26 AI:新增“AI自动接听电话”功能,可通过分析来电内容判断重要性,自动过滤骚扰电话或转录关键信息,系统能根据用户习惯(如通勤时间、常联系联系人)预判需求,例如自动弹出导航建议。

-

多模态交互

- Siri:仅支持语音交互,无法直接关联屏幕操作。

- iOS 26 AI:结合“屏幕感知”功能,可识别当前应用状态,用户查看日历事件时,可直接语音指令“帮我们改到下午2点”,系统会自动跳转编辑界面。

-

生态开放性

- Siri:长期局限于苹果生态,无法调用第三方服务(如微信、支付宝)。

- iOS 26 AI:通过API开放,允许第三方应用深度集成,用户可通过语音指令“用美团点一杯咖啡”,系统将自动跳转并完成订单。

技术升级背后的动机

苹果此次升级旨在解决Siri长期以来的两大痛点:

- 交互割裂:传统语音助手需频繁唤醒,且无法联动多任务;

- 生态封闭:拒绝第三方服务接入,限制了应用场景。

通过引入更强大的AI模型(如多模态大语言模型),iOS 26不仅提升了效率,还为AR/VR设备(如Vision Pro)铺平了技术路径。

FAQs

Q1:iOS 26的AI功能是否完全取代Siri?

A1:并非完全取代,Siri的品牌名称得以保留,但底层技术已升级为更先进的AI模型,原有功能(如基础语音指令)仍可用,但新增功能(如自动接电话、第三方集成)需依赖新AI架构。

Q2:第三方语音助手如何在iOS 26上运行?

A2:苹果首次开放了系统级API,允许第三方应用(如Google Assistant、讯飞语音)接入。

版权声明:本文由环云手机汇 - 聚焦全球新机与行业动态!发布,如需转载请注明出处。

冀ICP备2021017634号-5

冀ICP备2021017634号-5

冀公网安备13062802000102号

冀公网安备13062802000102号